Si queremos aparecer en los resultados de búsqueda, lo primero que deberemos hacer es conseguir que Google o cualquier otro motor de búsqueda, pueda interpretar el sitio web correctamente. Si no pueden leer el contenido, o no saben cuál pueden leer…. ¿Cómo van a saber que páginas tienen que mostrar y cuáles no?

Relacionado con la indexación web, hay unos elementos que debemos tener mucho en consideración: el archivo robots.txt, mediante el cual indicaremos a los robots las páginas y archivos a los cuales pueden acceder de nuestro sitio web. Un aspecto clave para diseñar cualquier estrategia SEO correctamente.

¿Qué son los archivos robots.txt?

Los archivos robots.txt son un archivo de texto mediante el cual proporcionamos información a los robots (bots, rastreadores…) sobre las páginas o archivos que pueden solicitar información o no en un sitio web. Mediante este archivo nos podremos “comunicar” directamente con los rastreadores.

Así pues, principalmente el archivo robots.txt se utiliza para no sobrecargar con solicitudes el servidor y para gestionar el tráfico de los robots en la página web, ya que en este archivo les indicamos el contenido que deben rastrear y el que no en un sitio web. Aquí tenemos que puntualizar que bloquear o no bloquear páginas, tiene un uso distinto al de la etiqueta «no-index»(explicado más adelante).

El archivo robots.txt se encuentra en la raíz del sitio web (www.nombreweb.com/robots.txt).

¿Cómo implementar los archivos robots.txt?

El archivo de robots.txt es un archivo de texto que se implementa en la raíz del dominio principal, por ejemplo: www.nombreweb.com/robots.txt. Aquí es donde incluiremos varios elementos para indicar a los rastreadores qué páginas deben ser rastreadas, y cuáles no.

Los archivos robots.txt se pueden crear en cualquier editor web, simplemente debes tener en cuenta que pueda crear archivos de texto UTF‑8 estándar.

¿Cómo implementar o modificar el archivo de robots.txt en WordPress?

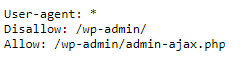

En general, de forma predeterminada el archivo de robots.txt se implementará en WordPress:

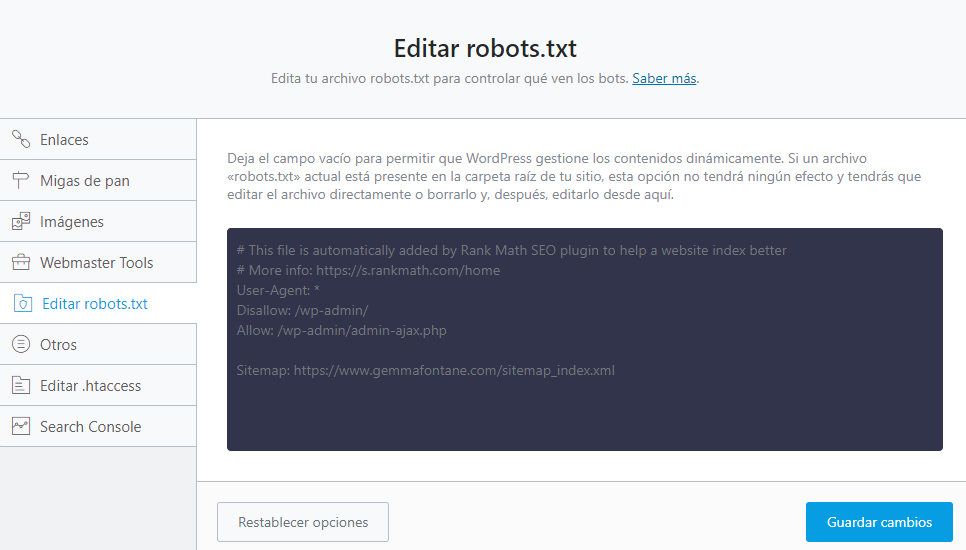

Asimismo, tenemos la opción de editar este archivo de varias formas. Por un lado, directamente desde el FTP de nuestro hosting o mediante diferentes plugins que puedes implementar en WordPress como Yoast SEO o Rank Math, desde donde se puede editar el archivo. Se debe tener muy presente, pero, que editar este archivo incorrectamente, puede afectar considerablemente los resultados de posicionamiento de la web, por lo que será importante informarnos bien de qué significa cada parámetro y cómo puede afectar a nuestra web.

En el caso de utilizar Rank Math en WordPress, por ejemplo, para editar el archivo deberemos ir a Rank Math > Ajustes Generales > Editar archivos Robots.txt

Aspectos a tener en cuenta para una correcta implementación

Para una correcta implementación, es importante considerar los siguientes aspectos, tal y como destaca Google

- El archivo debe llamarse robots.txt y solo puede haber uno por web.

- Los archivos robots.txt se pueden implementar individualmente en cada subdominio de una web.

- Los archivos robots.txt constan de uno o varios grupos con unas directivas concretas (siempre una por línea), que incluyan:

- a quién van aplicados (user-agent)

- a los directorios o sitios que este user-agent puede acceder y a los que no

- Predeterminadamente, los user-agent podrán rastrear todas las páginas que no estén indicadas como disallow. Y estos grupos se procesarán por el orden que estén escritos en el texto. Por lo que el grupo que incluya la regla más específica y sea el primero, será el que seguirá.

- Si hay dos normas que entran en conflicto, para Google y Bing siempre “gana” la directiva con más carácteres. Por lo que si tenemos un disallow con /page/ y allow con /page, va a tener más peso la primera. En cambio, si tienen la misma longitud, prevalece la menos restrictiva (vía Ahrefs).

Guía básica de los archivos robots.txt. ¿Qué parámetros debemos conocer?

A continuación, vamos a definir algunos de los elementos principales que son importantes conocer para poder interpretar e implementar los archivos robots.txt:

- User-agent (agente de usuario): son la forma de identificación de los rastreadores, definen las directivas que seguirán los distintos rastreadores, y deben incluirse siempre en cada grupo. Es importante destacar que cada motor de búsqueda tiene el suyo. Por ejemplo, el de Google se llama Robots de Google o Googlebot, el de Bing, Bingbot o el de Baidu, Baiduspider (base de datos de robots). Es importante destacar que se admite el siguiente caràcter (*), que sirve para que se aplique la directiva en todos los rastreadores.

- Directivas allow y disallow: estas directivas sirven para indicar concretamente al user-agent páginas que debe (allow) y páginas o archivos que no debe rastrear (disallow). Debe haber como mínimo una en cada grupo cuando se incluyen.

- Disallow: Para bloquear una página con la directiva disallow debe de especificar el nombre completo incluyendo / al final.

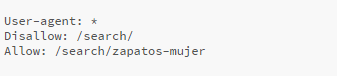

- Allow: la directiva allow, que anula la directiva disallow, suele utilizarse para indicar a los rastreadores que pueden rastrear algún apartado concfreto de un directorio bloqueado por la directiva disallow.

Allow y disallow, cuando le damos o le denegamos acceso a los robots de forma personalizada

Hay diversos aspectos que debemos tener en cuenta cuando configuramos las directivas allow y disallow en el fichero. Una incorrecta implementación puede afectar los resultados de la página en las SERPs. Así debemos tener en cuenta los siguientes parámetros.

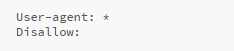

Si dejamos el archivo robots.txt de la siguiente forma, no bloqueará ningún directorio:

Pero si, por alguna cuestión (no recomendada a no ser que sea por un motivo consistente), ponemos solo la barra (/), bloquearíamos el rastreo de toda la página web (y no apareceríamos en los motores de búsqueda):

En cambio, si entre /…/ definimos un directorio, lo bloquearemos solo a este del rastrero. Cómo sería /wp-admin/. Es importante destacar, que si no incluimos la / final, los robots no rastrearán ninguna página que empezará con /wp-admin.

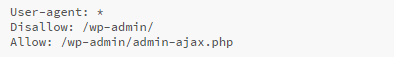

Asimismo, si dentro de esta exclusión, queremos indicar algún subdirectorio que pudiera rastrear, lo incluiremos como allow:

Otros elementos a tener en cuenta para el archivo robots.txt

Hemos visto que mediante el user–agent, así como directorios o URLs con el parámetro allow o disallow, podemos indicar a los robots distintos parámetros que pueden rastrear o no de la web.

A continuación, vamos a detallar algunos que nos podemos encontrar y que nos pueden ser de utilidad en función de los objetivos de nuestro proyecto. Pero cabe destacar que cada web es diferente, por lo que deberás analizar bien si te interesa alguno y por qué.

El *, para indicar “cualquiera” en el rastreo de los robots

Utilizar user–agent: * es una de las formas más fáciles para indicar a todos los robots (Google, Bing, Baidu…) que pueden rastrear todo el sitio web. Ya que es un comodín que utilizamos * para indicar que “cualquier” robot puede rastrear el sitio.

Así pues, si lo utilizas en user–agent, indicas a los robots que pueden rastrear todo el sitio web, y ya solo deberás detallar con el elemento disallow, aquellos directorios que no quieras que accedan:

Por otro lado, también se puede utilizar * en URLs, ya sea en el principio o en el medio, y tiene el mismo significado: todos / cualquiera. En este caso, por ejemplo, bloqueamos cualquier URL como www.miweb.com/retail/red/jumper o www.miweb.com/retail/small/jumper.

Indica el final de una URL con el símbolo $

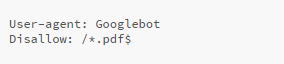

Para indicarles a los robots el final de una URL se puede usar el símbolo $. Por ejemplo, se puede usar con disallow: *.php$, que bloquearía la URL terminada así, pero sí que aceptaría otra como: .php/cualquietermino. Eso sería para sí nos interesa que rastreara algunas URLs particulares de estos archivos.

Impedir que rastreadores visiten el sitio web

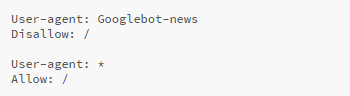

En función de nuestra estrategia, tal vez no nos interesa que algunos robots concretos rastreen el sitio web. Este aspecto, se indicaría de la siguiente forma:

La #, para explicar comentarios

Si queremos hacer algún comentario sobre cualquier aspecto, pero sin dirigirnos a los robots, lo haremos con la #. Ya que los robots no leerán todo lo que haya después de #.

¿Disallow o etiqueta no-index?

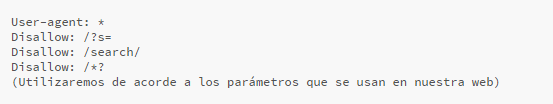

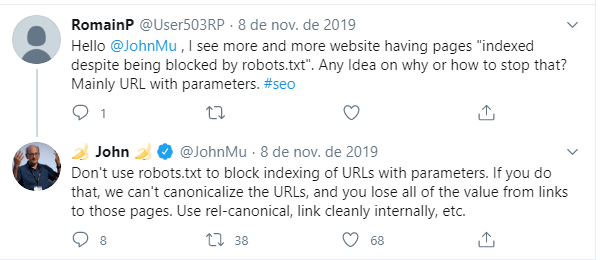

Otros elementos que podemos usar en el archivo de robots.txt son aquellos que nos ayudarán a bloquear la entrada de los robots a URLs, como por ejemplo a URLs con parámetros, que se crean cuando los usuarios utilizan el buscador de una página web o filtran productos según unos parámetros concretos, o cuando no queramos que alguna página se indexe en los buscadores porque no es relevante (política de privacidad…).

Antes de incluir esta directiva como disallow en una página web, es muy importante valorar correctamente si incluirla puede ser de gran utilidad o no. Una decisión que, como ya hemos comentado anteriormente, variará en función de nuestra web y objetivos.

Indexación de contenido con la la metaetiqueta «robots»

Con la metaetiqueta “robots” podremos especificar a nivel de página como se debe indexar el contenido en las búsquedas, en caso de que no queramos que alguna página se muestre en los resultados.

Pero para poder indicar a un robot está directiva, es importante que la pueden leer. Por lo que bloquear una URL que incluye la etiqueta “no index” en robots.txt, será un error. Ya que los robots no podrán leer aquella página y, aunque tal vez les sea difícil encontrarla, puede que al cabo de un tiempo se indexe, ya que los robots acaben llegando a ella mediante enlaces de otros sitios web.

¿Cuál será nuestra mejor opción cuando tengamos URLs con parámetros, “no-index” o disallow?

Dejando a un lado de que será variará en función de los objetivos de cada web, lo que tendremos que preguntarnos es:

- ¿Nos interesa que los robots inviertan tiempo analizando las URLs con parámetros que se crean cuando alguien utiliza el buscador del sitio web?

- ¿Nos interesa que los robots inviertan tiempo analizando las URLs con parámetros cuando alguien filtra productos?

En función de la respuesta, diseñaremos nuestra estrategia.

Finalmente, otra opción que podemos puntualizar es que, aunque decidimos que nos interesa que las búsquedas en el sitio web realizadas por los usuarios estén bloqueadas, tal vez queramos hacer excepción con algunas concretas, ya que pueden ser términos de interés, que nos pueden ayudar a aumentar la visibilidad. En este caso, por ejemplo, pondríamos:

Bloquear URLs con etiquetas canonicals

La etiqueta canonical la utilizamos para evitar tener contenido duplicado en una página web. Unas etiquetas que, en ocasiones, utilizamos en URLs parametrizadas – las cuales tienen contenido muy similar a la principal de producto o categoría – para prevenir crear contenido duplicado.

No te pierdas el blog: ¿Cómo evitar contenido duplicado?

De este modo, si bloqueamos las URLs con parámetros al archivo de robots.txt, impediremos que los robots puedan leer dicha información e identifiquen cuál es la página “principal”, especialmente cuando filtremos productos, tal y como indicaba John Mueller (Google):

Otra opción que tendremos será bloquear URLs con parámetros concretos, lo cual se hace mediante Google Search Console.

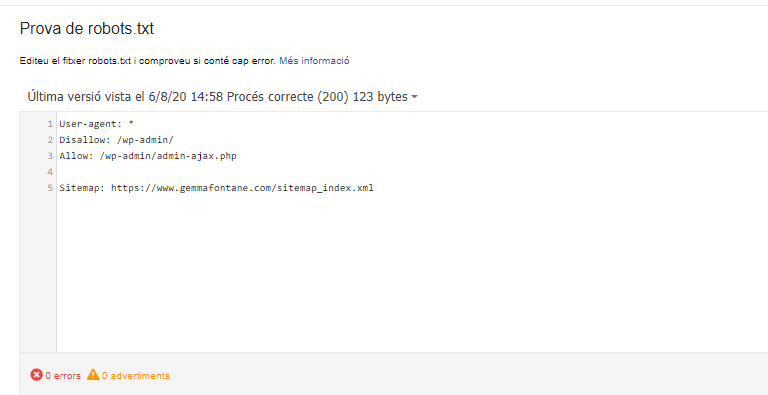

Incluir el sitemap en el archivo robots.txt

Aunque no es “obligatorio” incluir el sitemap, el archivo que proporciona información sobre la estructura de la web, es recomendable incluirlo o incluirlos, ya que así indicamos a Google el contenido que nos interesa que rastree.

¿Cómo comprobar que hemos implementado correctamente el archivo robots.txt?

Finalmente, después de tener y valorar todos estos aspectos, solo hay una cosa que, como siempre, deberemos hacer: comprobar que lo hayamos implementado correctamente en el sitio web.

Lo podremos comprobar en el “Probador de Robots.txt” de Google Search Console o directamente cada URL.

¿Deseas más información sobre cómo Google interpreta el archivo robots.txt?

Si deseas más información para tu sitio web sobre cómo Google interpreta el archivo robots.txt, puedes ponerte en contacto conmigo.